Nachdem sich Teil 1 meines kleinen Hardwareüber- und Ausblicks auf Prozessoren konzentriert hat, folgt nun Teil 2, der sich den mit Prozessoren stark zusammenhängenden Chipsätzen widmet.

Teil 2: Chipsätze

Bei den Chipsätzen geht die allgemeine Entwicklung leider noch langsamer voran als bei den CPUs – was schon eine “erstaunliche Leistung” ist. Denn während man bei den CPUs noch argumentieren kann, dass momentan in Alltagsszenarien kein Bedarf für mehr Rechenkraft vorhanden ist und die Umstellung auf 14nm schlichtweg Zeit braucht, gibt es bei den Chipsätzen durchaus neue Technologien, die man eigentlich in den Chipsatz hätte integrieren können. Aber hier treten sowohl Intel als auch AMD auf die Bremse. Nun bin ich natürlich kein Ingenieur. Möglicherweise gibt es einfach nur große technische Hürden bei der Integration weiterer Funktionen zu überwinden. Dennoch finde ich es sehr traurig, dass man seit Jahren einen erheblichen Mangel an PCIe-Lanes hat und technische Weiterentwicklungen erst sehr spät berücksichtigt werden.

Ersterer Punkt führt beispielsweise dazu, dass man aktuell sowohl mit den 8er-Chipsätzen für Haswell als auch den 9er-Chipsätzen für Broadwell “nativ” maximal sechs S-ATAIII-Anschlüsse zur Verfügung hat. Möchte man mehr, ist man auf externe Zusatzchips angewiesen. Zudem ärgern sich SLI/Crossfire-Freunde seit Jahren darüber, dass man das GPU-Gespann nur im 2×8-Modus nutzen kann statt im optimalen 2×16-Modus. Zu guter letzt leiden aber auch neue Funktionen wie S-ATA-Express (wird entgegen der ursprünglichen Ankündigung sowieso nicht nativ unterstützt) oder der neue M.2-Standard für SSDs unter diesem Flaschenhals, da man sie aufgrund mangelnder Links einerseits nicht parallel nutzen kann beziehungsweise sie andererseits selbige abzwacken wodurch sie dann an anderer Stelle fehlen. Zudem: Bei der von Intel vorgesehenen Aufteilung der vorhandenen Lanes wird der M.2-Slot nur mit halbierter Bandbreite benutzt.

Natürlich: Das ist Meckern auf hohem Niveau. Den allermeisten reichen sechs S-ATAIII-Ports (oder auch sechs USB3.0-Ports), auch ist die Anzahl von SLI/Crossfire-Nutzern überschaubar (zudem leidet die Leistung nicht erheblich unter dem 2×8-Modus). Und dennoch nervt dieser Stillstand. Zumal diese Knappheit auch praktische Nachteile im Komfort hat. So müsst ihr beim Zusammenbau eines neuen PCs akribisch darauf achten, welche Anschlüsse ihr nutzt. Denn wie gesagt: Nicht alle bieten volle Leistung (S-ATA, USB), andere wiederum schließen sich gegenseitig aus. Eine weitere konkrete Folge ist die selbst für Profis nur schwer zu durchschauende Vielzahl verschiedener Mainboardvarianten auf dem Markt. Hier sollte man ganz genau hinschauen, bevor man eine Kaufentscheidung trifft.

Ein Beispiel für das Ignorieren bereits bestehender Technologien ist aktuell, dass man – obwohl der Standard bereits angekündigt und daher bekannt ist – selbst bei den Mitte 2015 erscheinenden 100er-Chipsätzen für Intels Skylake nach aktuellem Informationsstand nicht auf USB 3.1 setzen wird. Das ist sehr ärgerlich, bringt dieser Standard neben mehr Geschwindigkeit doch vor allem auch die “geniale” Neuerung, dass beim Anschließen des Kabels nicht mehr auf die richtige Ausrichtung geachtet werden muss. Wer kennt das nicht: erster Versuch, das USB-Kabel anzuschließen -> verdammt, falsch herum -> zweiter Versuch mit umgedrehtem Kabel -> verdammt, immer noch falsch herum -> dritter Versuch -> ah, jetzt geht’s ![]() . Zudem bin ich gespannt, ob Intel ab der 100er-Serie HDMI2.0 unterstützen wird. Ich bin da ja eher pessimistisch. An der Problematik mit den PCIe-Lanes wird sich wohl ebenfalls nichts ändern.

. Zudem bin ich gespannt, ob Intel ab der 100er-Serie HDMI2.0 unterstützen wird. Ich bin da ja eher pessimistisch. An der Problematik mit den PCIe-Lanes wird sich wohl ebenfalls nichts ändern.

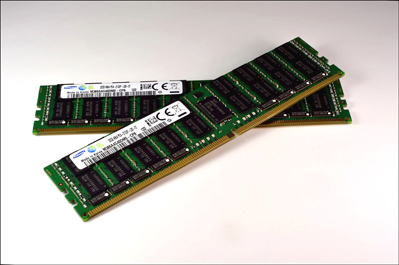

Bereits gesichert – und damit Hauptargument für das Warten auf die Skylake-Prozessoren anstelle eines Kaufs der parallel erhältlichen Broadwell-Vertreter: DDR4 wird nativ unterstützt und ein neuer Sockel (mit 1151 Pins) verwendet. Zudem ist bekannt, dass bei der 100er-Serie neue (unter anderem deutlich schnellere) Thunderbolt-, W-Lan- und LAN-Chips verwendet werden. Insbesondere Thunderbolt solltet ihr dabei im Blick behalten, da vorgesehen ist, diesen “zum Start der Skylake-Plattform als Lösung für alles […] zu vermarkten. Über ein einziges Kabel können zwei 4k-Bildschirme versorgt und gleichzeitig Daten übertragen sowie externe Geräte geladen werden”. Ob und wie das letztlich in der Praxis aussieht, ist natürlich ein anderes Thema. Generell muss zum Thema Skylake bzw. der 100er-Chipsatzserie erwähnt werden, dass es noch mindestens ein Jahr bis zur Veröffentlichung hin ist. Es ist also durchaus möglich, dass die eine oder andere Neuerung noch angekündigt wird.

Zusammenfassung

Das Thema Chipsätze ist sehr komplex. Ich habe hier bewusst nur eine sehr oberflächliche und sicherlich unvollständige Darstellung geboten. Gerade bezüglich der PCIe-Lanes und deren Verwendung und Aufteilung kann man seitenweise sehr interessante Artikel im Netz finden. Meine persönliche, stark verkürzte Meinung ist aber ganz klar, dass man hier den technologischen Möglichkeiten stark hinterherhinkt. Mein Traum eines “kompletten” Mainboards ohne Zusatzchips wird auch 2015 weiterhin nicht erfüllt.

Und dennoch: Mit DDR4, dem neuen “zukunftssicheren” Sockel LGA 1151, dem deutlich schnelleren Thunderbolt, den neuen (W)LAN-Chips und ggf. weiteren Neuerungen sind die 100er-Chipsätze auf alle Fälle interessanter und empfehlenswerter als die zuletzt vorgestellten 8er- und 9er-Reihen. Auch hier gilt also: Wer mit dem Gedanken spielt, sich einen neuen Rechner zu kaufen, wäre gut beraten noch etwas abzuwarten.

Dies gilt im Übrigen auch für die AMD-Anhänger unter uns. Der Grund weshalb ich AMD in diesem Artikel komplett außen vor gelassen habe ist der, dass AMD – meiner bescheidenen Meinung nach – aktuell im direkten Vergleich mit Intel einfach zu unattraktiv für Desktop-Nutzer ist. Es gibt jedoch ein paar sanfte, wenn auch sehr vage Signale, dass AMD ab 2015/2016 im Desktopsegment wieder angreifen möchte. Es wäre wünschenswert. Nicht nur für AMD-Freunde. Sich zum jetzigen Zeitpunkt aber ein neues System auf AMD-Basis zu kaufen kann ich definitiv nicht empfehlen.

Während Prozessoren und Chipsätze in der Summe also auch in 2015 weiterhin dem bisherigen Motto der “kleinen Trippelschritte” folgen, versprechen die Neuerungen im visuellen Bereich revolutionär zu werden. Mehr dazu folgt im spannenden Finale dieser Artikelreihe in den kommenden Monaten.

Das tolle Erklärbärbild habe ich gemalt, nur um das nochmal zu betonen!

Zum Thema: Ich sehe das, anders als du, wie bei den CPUs. Uns geht es einfach schon zu gut. Die Leistung wird einfach nicht gebraucht. Deswegen ist DDR4 immer noch kein Standard, deswegen interessiert es seit praktisch Jahren keine Sau mal den Engpass zwischen Steckplatz (wer hat schließlich überhaupt noch irgendwas in den Steckplätzen drin?!) und restlichem System aufzulösen (da hat anscheinend nicht einmal ein nVidia eine Möglichkeit Druck aufzubauen) und selbst SSDs und USB 3.0 sind noch lange nicht so weit verbreitet wie sie schon sein könnten weil für den normalen Nutzer die aktuelle Situation völlig ausreichend ist. Ob er jetzt eine Minute länger warten muss oder nicht interessiert doch nicht. Vor allem nicht die Büroarbeiter, die es sowieso gewohnt sind, dass alles was mit Computern zu tun hat viermal so lange dauert wie daheim.

Joa, stimmt definitiv. Ich mache Intel hier ja auch nicht wirklich einen Vorwurf. Ökonomisch ist das schon alles sinnvoll, was die da machen.

Es ist halt nur schade, wenn man – im Gegensatz zum Großteil der PC-Nutzer – weiß, was theoretisch machbar wäre, aber nicht umgesetzt wird.

Es brauch wieder mehr Pioniere und mutige Entwickler. Ob das in der heutigen Zeit aber noch machbar ist, ist natürlich die andere Frage. Ich mein: selbst über Kickstarter ist mir – bis auf Star Citizen und Oculus – kein Projekt bekannt, dass eine gänzlich neue Rechnergeneration nötig machen würde. Wobei das Thema VR natürlich extrem hardwarehungrig sein wird. Bis sich das aber durchsetzt und sich auch die Mehrzahl der Leute eine solche Brille aufsetzen wollen, werden leider noch mehrere Jahre vergehen.

Also mir könnten Chipsätze kaum egaler sein. Ob DDR4 unterstützt wird und wieviele PCIe Lanes zur verfügung stehen und die meisten anderen wichtigen Sachen sind doch nurnoch von der CPU abhängig, seit die Northbridge da reingewandert ist. Was macht denn der Chipsatz noch? USB, SATA, Ethernet und die lahmen PCIe Steckplätze. Damit kann man mich nicht mehr vorm Ofen hervorlocken, seit USB3.0 und SATA6G doch irgendwann mal endlich Standard geworden sind (und viele brauch ich davon auch nicht).

Und selbst an deren beschränkter Anzahl sind ja wiederrum nicht die Chipsätze schuld, sondern die fehlenden PCIe bzw. DMI Lanes…

Und warum soll VR so übermäßig Hardwarehungrig sein? Selbst wenn du vor jedes Auge ein FullHD Display klemmst und es mit 60fps befeuerst ist das doch nichts, was nen halbwegs guten heutigen GamerPC in die Knie zwingt. Und was da nebenher noch dazu kommt dürfte nicht der Rede wert sein.

@Ron

ja, DDR4 wird keinen großen Unterschied im Desktopbereich machen. Bestenfalls im mobilen Sektor, da etwas sparsamer. USB3.1 hingegen ist schon “wirklich nett”

Aber die wenigen lanes halte ich definitiv für problematisch. Ich bin ein Freund möglichst “schlanker” Mainboards, also ohne viel Zusatzchips. Am besten keine. Und das lässt sich eben nur realisieren, wenn mehr lanes zur Verfügung stehen und der Chipsatz überarbeitet wird. Ich bin auch kein Freund von “Mischungen” a la 6xUSB2.0 und 4xUSB3.0 etc. Wenn, dann richtig.

Und bezüglich VR:

du hast die 3D-Berechnung vergessen. Du hast quasi 2x 960*1080, musst das auf mindestens (!) 60fps bringen und dann noch 3D berechnen (das halbiert in der Regel die Bildrate).

Beispiel (ganz grob und ohne Recherche):

Crysis 3 läuft selbst auf einer 780GTX Ti nur mit 39fps in FHD. Auf einem Bildschirm und ohne 3D. Man kann nur sehr grob schätzen, wie es hier mit VR aussieht, aber ich schätze mal, dass wir unter die 20fps fallen, wenn man das ganze mit Oculus spielen möchte.

Klar, Crysis 3 ist ein extrem anspruchsvolles Spiel. Aber ich denke, VR ist erst dann so richtig beeindruckend, wenn auch die Grafik hervorragend ist. Trotzdem: um in einer VR-Umgebung 60fps zu erreichen, sollte mMn ein Spiel unter “traditionellen Bedingungen” mit mindestens 120fps berechnet werden können. Und das schafft auch eine GTX780 Ti (für immerhin 600 Euro!) nur in Einzelfällen.

Nur wenn man den Anspruch hat alles auf Ultra zu stellen ;) Ein paar Features reduzieren und die 120fps sind doch bei den allermeisten Spielen überhaupt kein Thema mehr.

Farcry fällt da ein bisschen raus, aber ansonsten schaffen das die HighEnd Grakas auch ohne Reduzierung, laut CB Test (die testen diese ja bei 2560*1600, was schon doppelte FullHD Auflösung ist)

Achja und was die “Mischung” von USB3.0 und 2.0 angeht kann ich dir gar nicht genug zustimmen. Und imho gilt für mich da auch die “zu wenig Lanes”-Ausrede nicht. Klar ist es richtig, dass heutige Chipsätze 10 USB3.0 Ports nicht jeweils mit voller Datenrate bedienen können. Aber das Problem hat man doch eh immer. In der Theorie können nichtmal 4 SATA 6G Ports voll bedient werden und damit is dann der gesamte Bus zwischen CPU und Southbridge dicht…

Aber es benutzt doch auch niemand alle Schnittstellen gleichzeitig. Warum nicht also bei allen Ports volle potentielle Geschwindigkeit bereitstellen, auch wenn diese im Parallelbetrieb halt nicht immer erreicht wird.

Es ist sooo nervig… Mein Gehäuse hat 4 USB3.0 Front (bzw. eher Top) Anschlüsse, musste aber mangels Schnittstellen auf dem Board 2 davon als USB2.0 anschließen. Jetzt muss ich also immer wissen, dass ich meinen USB3.0 Stick nur in die vorderen 2 reinstecken darf. Sowas hinterwälderisches ;) Selbst wenn die 4 am gleichen Controller hängen würden und sich die Bandbreite teilen müssten wär mir das tausendmal lieber als diese Gemurks.

Ich glaube Intel liest mit und sie haben sich deiner Kritik angenommen.

https://www.computerbase.de/2014-07/intel-skylake-chipsatz-z170-h170-q170-q150-b150-h110/

BIs zu 20 PCIe lanes, die jeweils dank PCIe 3.0 doppelte Datenrate liefern. Das klingt zumindest mal nach ner Hausnummer.

Yay, das ist definitiv mal eine sehr gute Nachricht! Auch wenn im Forum die ganz Anspruchsvollen beklagen, dass trotzdem nicht alle Flaschenhälse beseitigt wurde :)

Aber immerhin: das macht Skylake nun definitiv attraktiver als Broadwell. Hier endlich mal wieder ein spürbarer Schritt nach vorne unternommen.

Naja, der VorpX-Treiber für die Rift beweist: 3D muss keine Performance kosten. Der Entwickler verpasst den Spielen dort per Z-Buffer einen beeindruckenden 3D-Modus, der kaum 2-3% Leistung kostet und nur für geschulte Augen schlechter aussieht als die Holzhammermethode “doppelte Berechnung”.

Ähnliches ist ja schon bei Crysis 2 zu beobachten gewesen, Crytek hat für den 3D-Modus auch mit allen möglichen Tricks gearbeitet und so einen extrem performance-schonenden Modus geschaffen. Sowas mag ich.