Es ist mal wieder so weit: der Webmaster schreit nach einem Gastbeitrag und nachdem sich die erste Panik gelegt hat und die peinlichen Versuche, sich mit schlechten Ausreden davonzuschleichen, gescheitert sind, macht man es halt doch: Ich entscheide mich gegen das Schauen diverser WM-Spiele und beginne zu schreiben. Und zwar über das einzige Thema, dass ich mir halbwegs ohne große Recherche aus dem Ärmel schütteln kann: Hardware. Jawohl, mal wieder Hardware. Nach wie vor ist es so, dass zwar mein Interesse an Spielen (bzw. dem Spielen der selbigen) sehr stark schwankt, meine Leidenschaft für die Technik aber nach wie vor uneingeschränkt ist. Obwohl ich also eigentlich keinen Bedarf habe, durchstöbere ich täglich mehrfach das Internet nach Neuigkeiten über Hardware. Paradox.

Und apropos “kein Bedarf”: Bringen wir eine der Hauptaussagen des Artikels gleich mal hinter uns. In nahezu jeder Hinsicht ist es – mal wieder beziehungsweise immer noch – ein schlechter Zeitpunkt sich neue Hardware zu kaufen. Einerseits eben, weil sich nichts an der Situation geändert hat, dass Mittelklasse PCs für fast alle aktuellen Spiele in FHD und hohen Details ausreichen. Andererseits, weil der Hardwaremarkt stagniert und sich bestenfalls in Trippelschritten vorwärts bewegt. Wir PC-Spieler, besonders die technisch anspruchsvollen, werden unverändert gefoltert. Stillstand wohin man schaut. Seit Jahren die immer gleichen, innovationslosen, technisch unspektakulären Spiele. Und entsprechend auch seit Jahren der gleichbleibende, mittelmäßige Anspruch an die Hardware. In gewisser Weise ist das natürlich ein schöner Umstand: man kann ohne neue Kosten seit Jahren in aller Ruhe weiterzocken. Kombiniert mit den regelmäßigen Verkaufsaktionen auf den einschlägigen Vertriebsplattformen ist das Hobby “PC-Gaming” seit langer Zeit nahezu kostenlos. Zumindest für die geduldigen Naturen unter uns. Und dennoch sind zumindest bei mir der Trieb und das Bedürfnis vorhanden, endlich den nächsten Schritt zu gehen. Endlich wieder einen Aha-Moment zu erleben. Etwas Neues, noch nie dagewesenes, etwas Spektakuläres. Etwas, dass mich auch mit meinen nunmehr 30 Lenzen stolz und laut sagen lässt: “Jawohl, ich bin begeisterter PC-Spieler!” Wie gerne ich das hinausschreien würde. Aber die Industrie macht es mir seit einer Ewigkeit sehr schwer.

Immerhin, und damit rette ich nun den Artikel gerade noch so vor einem kompletten depressiv-pessimistischen Einschlag, gibt es einige Anzeichen, dass sich das ab 2015 ändern wird. In nahezu allen elementaren Aspekten stehen uns spürbare Veränderungen bevor. Teil 1 meiner kleinen Serie widmet sich zuerst den Prozessoren.

Teil 1: Prozessoren

Was passiert, wenn ein Unternehmen den Markt dominiert, lässt sich seit einiger Zeit prima anhand von Intel beobachten. Seit Sandy Bridge im Januar 2011, also vor über drei Jahren, auf den Markt kam, hat sich nicht mehr viel Bemerkenswertes getan. Natürlich: Sandy Bridge war eine herausragende Prozessorarchitektur und hat in vielerlei Hinsicht die Messlatte ein ganzes Stück nach oben gesetzt. Ein i5-2500K beispielsweise ist auch heute noch ohne Abstriche ausreichend für nahezu alle denkbaren (Gamer-)Szenarien. Ivy Bridge (2012), Haswell (2013) und der aktuelle Haswell Refresh (2014) haben – sehr verkürzt und vereinfacht formuliert – keine tiefgehenden Veränderungen und vor allem keine wirklich spürbaren Leistungssteigerungen mehr gebracht. Ein Intel i5-4690 (Haswell Refresh) ist in realistischen Spieleumgebungen (FHD, max. Details) zum Beispiel nur 8% schneller als sein über drei Jahre alter Vorläufer i5-2500K (Sandy Bridge). Bei Anwendungsbenchmarks, die die CPU mehr fordern sind es immerhin 22% (alles basierend auf Testresultaten von Computerbase.de). Hätte sich wenigstens die Energieeffizienz deutlich verbessert, könnte man darüber hinwegsehen. Aber weder bei der Leistungsaufnahme noch bei den Temperaturen konnten Fortschritte erzielt werden. Im Gegenteil: Je nach Szenario verbraucht ein Haswell Refresh etwas mehr Strom (immerhin auch bei etwas mehr Leistung) und wird deutlich wärmer. Dass über die vielen Jahre natürlich das ein oder andere Feature hinzugekommen ist, soll an dieser Stelle ignoriert werden. Was für den Otto-Normal-Nutzer am Ende des Tages wichtig ist, ist die Leistung in den Standardanwendungen. Und hier hat sich leider viel zu wenig getan in den letzten dreieinhalb Jahren.

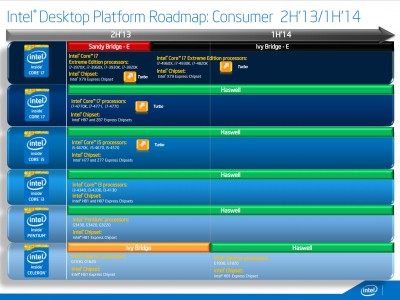

Für die nächsten 12 Monate kündigte Intel nun gleich zwei neue Prozessorgenerationen an: Broadwell (Q4/2014-Q2/2015) und Skylake (ab Q2/2015). Über die Gründe, weshalb Intel diesen verwunderlichen Schritt geht und quasi parallel einen Tick und einen Tock auf dem Markt führt, kann aktuell nur spekuliert werden. Das in meinen Augen plausibelste Argument ist das, dass Intel vor allem im Mobile-Bereich unter enormen Zeit- und Erfolgsdruck steht und daher Broadwell so schnell wie möglich veröffentlichen muss. Daher starten auch die mobilen Vertreter zuerst. Und noch in 2014. Und in der Tat, Broadwell könnte etwas Revolutionäres gelingen: Lüfter- bzw. wenigstens lautlose Mittelklasse-Notebooks (erste Geräte sind bereits angekündigt). Bei etwas Ingenieurskunst und hochwertigem Kühlkonzept womöglich sogar in der Oberklasse. Möglich wird dies natürlich vor allem durch den Sprung von 22nm auf 14nm. Entsprechend dürften auch die im Q2/2015 folgenden Desktopvertreter endlich wieder etwas stromsparender und kühler werden als selbige aus der Haswell-Generation. Ob sich hingegen bei der Leistungsfähigkeit (abseits der obligatorischen ca. 10% Zugewinn) etwas tut, darf bezweifelt werden. Schließlich ändert sich nicht die Architektur, sondern nur der Fertigungsprozess.

Für Desktopnutzer – und diese stehen in meiner Betrachtung im Mittelpunkt – wäre ein Umstieg auf Broadwell also nur bedingt empfehlenswert. Zu klein ist in meinen Augen der Unterschied zu den Vorgängern. Notebooknutzer oder jene, die es werden wollen (dazu gehöre ich), können sich aber auf eine spürbare Verbesserung einstellen. Diejenigen, die sich einen performanten Tischrechner zum Zocken und anspruchsvollen Arbeiten basteln wollen, wären – basierend auf der aktuellen Informationslage – aber durchaus besser damit beraten auf Intels Skylake zu warten. Dies liegt weniger an der zu erwartenden Leistung (die man sowieso zum jetzigen Zeitpunkt nicht einschätzen kann), sondern vielmehr an den neuen Chipsätzen der 100er-Reihe. Diese bringen zwar vermutlich keine Revolution und behalten weiterhin einige Ärgernisse der aktuellen und vergangenen Chipsätze, führen aber wenigsten ein paar kleinere, neue Technologien ein, die man im Sinne einer maximal möglichen Zukunftssicherheit durchaus mitnehmen sollte. Was es genau damit auf sich hat, erfahrt ihr in Teil 2 meiner heiteren Artikelserie am kommenden Donnerstag.

Kleiner Fehler: die Desktop-Broadwells kommen natürlich in Q2/15, nicht in Q2/14 (das würde ein bisschen knapp werden mit den verbleibenden vier Tagen).

Und Sic: ne ältere Roadmap haste nicht finden können, oder?

Das ist Intels offiziell bereitgestellte Roadmap. Alles andere würde ich nur irgendein Copyright verletzten wenn ich es genommen hätte.

Zum Thema: Ich stimme zum einen natürlich zu, dass wir weiterhin unter mangelndem Bedarf leiden. Zwar werden die Hardwareanforderungen bei Konsolenports jetzt auch erstmal wieder steigen in der aktuellen Generation. Das liegt aber nicht daran, dass die Power wirklich notwendig ist, sondern mehr weil die Entwickler noch nicht so gut mit Xbox One und PS4 zurecht kommen und entsprechend schon der ursprüngliche Code nicht gescheit ist. Da kann natürlich auch der Port keine Wunder wirken. Insofern finde ich — mal die Streitigkeiten um GameWorks zwischen AMD und NVidia außen vor gelassen — prinzipiell gut, dass nVidia (vermutlich aus Trotz weil AMD alle Konsolen antreibt) jetzt so extrem stark die PC-Ports puscht. Leider halt nur im Grafikbereich.

Zum anderen ist aber auch durchaus die Frage, was speziell im Bereich der Prozessoren Leistungsmässig mit den aktuellen Prozessen/Methoden überhaupt noch möglich ist. Aus Laiensicht sehe ich seit Jahren nur eine Erhöhung der Anzahl der Kerne aber die eigentliche Power pro Kern steigert sich irgendwie nicht (rein in Ghz ausgedrückt, dass sich unter der Haube natürlich schon was tut ist klar wie du ja auch oben anhand der Benchmarks zeigst). Ohne Turbo-Modus kamen doch weder AMD noch Intel bislang über die 4GHz. Der kommende Refresh des i7-4770k ist doch, wenn ich das richtig lese, die erste native 4Ghz-CPU. Stattdessen knörzen wir immer noch bei 3,0-3,5 rum standardmässig. Das sehe ich aber auch auf dem GPU-Markt auf uns zukommen. Auch da fängt es so langsam an damit, dass es mehr in Richtung “gleiche Leistung bei weniger Verbrauch” beziehungsweise per Software mehr Power rausgeholt wird als, dass tatsächlich signifikant mehr Power dahinter steckt. Wenn ich mir anschaue wie extrem die Schwankungen teilweise sind nur zwischen einer Treiberversion und der nächsten. Da läuft doch irgendetwas massiv falsch.

Ja, Gamer bekommen seit Jahren nichts mehr zu sabbern. Aber wie auch, AMD hat den Konkurrenzkampf im Highend aufgegeben, Intel braucht sich keine Mühe machen. Für 99% der Anwender reicht die Performance selbst von Mobilprozessoren. Die meisten kommen inzwischen sogar mit einem Bay-Trail-Atom hin.

Und gerade im ULV-Bereich hat sich dann doch einiges getan, da wurde auch geforscht und entwickelt. Das finde ich als ebenfalls Hardwarebegeisterter dann auch wieder spannend – weg von den glühenden Drölftrilliarden-Prozessorkern-CPUs hin zu energiesparenden Designs. Bay Trail bietet vier Rechenkerne mit gar nicht SO schlimmer Rechenleistung zum Sonderpreis und mit unter 10 Watt TDP. Ein 200-Euro-Tablet packt inzwischen Windows 8.1 mit zwar immer noch gewöhnungsbedürftiger aber dennoch gleichfalls erstaunlicher Performance. Und die kleinen Mobil-Core-i-CPUs haben inzwischen genug Grafikleistung um damit auch mal spielen zu können. Mein NUC im Wohnzimmer erstaunt mich jeden Tag mehr als es ein 8-Kern-Haswell-E tun würde.

@Sic

ich kann da natürlich auch nur mutmaßen, aber mein subjektives Gefühl sagt mir auch, dass im Bereich Codequalität einiges schief läuft. Alleine schon, weil es dem wirtschaftlichen Interesse widerspricht, einen hochwertigen, hochperformanten Code für den Gaming-Sektor zu entwickeln. Denn einerseits kostet eine sorgfältige Programmierung viel mehr Zeit (und damit Geld), andererseits würde man den Hardwaremarkt ja noch mehr schädigen, wenn plötzlich Computer im Wert von 500 € für absolute High-End-Titel ausreichen. Das ist weder im Interesse der Konsolenhersteller (Sony, MS) noch von Hardwareherstellern (Intel, AMD). Und einen wirtschaftlichen Nutzen für die Programmierer gibts auch nicht. Kurzum: es macht keinen Sinn, mehr Aufwand in gute, effiziente Programmierung zu stecken.

Dass es aber prinzipiell geht, hat ja AMD mit Mantle bewiesen. Und plötzlich springt auch MS auf den Zug auf (mit DX12).

Bezüglich der Anzahl von CPU-Kernen: das Thema hängt natürlich mit der Codequalität eng zusammen. Ich denke schon, dass auch sechs oder acht Kerne grundsätzlich einen Mehrwert haben KÖNNTEN, wenn man denn bei der Softwareentwicklung mehr Wert auf die Verteilung der Rechenlast setzen würde. Aber generell: solange man nicht endlich mal das Thema KI ernsthaft angeht und weiterentwickelt, sehe ich bei CPUs sowieso erstmal keinen wirklichen Bedarf für größere Leistungssprünge. Hauptthema bleibt nach wie vor die Rechenleistung des Grafikprozessors.

@Dod

ja, definitiv! Bedingt durch die Stagnation im “Hochleistungsbereich” haben die Themen Effizienz, Emission und Verarbeitungsqualität auch für mich einen ganz neuen Stellenwert gewonnen. Also auch auch Lautstärkeentwicklung, Temperaturentwicklung, Softwarequalität, Haptik, Optik. Ich freue mich momentan wirklich sehr auf die ersten Ultrabook mit Broadwell-CPUs (und Maxwell GPU). Mit etwas Glück kommen da erstmals leistungsfähige und dennoch leise, schlanke und sehr schöne Geräte auf uns zu.

Ich freue mich schon gar nicht mehr auf neue Ultrabooks oder Notebooks. Sondern auf Tablets mit Keyboarddock, die trotzdem all das können, was ein Ultrabook ausmacht. DAS ist spannend und ein Blick in die Zukunft.

Ich habe ja für Computerbase zwei preiswerte Windows-Tablets getestet und war schon erstaunt, was die inzwischen leisten.

Ja, ich beobachte auch gespannt das neue Surface Pro 3 Pro. Ich bin da aber noch etwas verhalten mit meiner Begeisterung. Mein Vater hat ein Asus Transformer der noch aktuellen Generation – und das ist in meinen Augen in jeder einzelnen Disziplin zwar “solide”, aber nirgends so richtig gut. Hinzu kommen einige ärgerliche Bugs. Aktuell erscheint mir der Kauf zwei separater Geräte noch sinnvoller als der Kauf eines Einzelgerätes. Aber ja, es ist wohl nur eine Frage der Zeit, bis sich das ändern wird.

Um kurz zurückzugehen: Effiziente Programmierung ist definitiv ein guter Ansatz. Und es ist gut, dass MS versucht hier wieder einen Standard zu schaffen. Leider hat die Vergangenheit gezeigt, dass es MS mit ihrem ständig wieder ausgesprochenen “PC-Gaming ist uns wichtig! Ehrlich jetzt. Da wird sich einiges tun” überhaupt nicht ernst zu meinen scheint. Von daher glaube ich nicht, dass mit DX12 die Erfüllung kommen wird. Mal abgesehen davon, dass dann wieder das Konsolenproblem mit reinspielt. DX10 und 11 sind ja immer noch kein völlig durchgesetzter Standard. Von OpenGL brauchen wir erst gar nicht anfangen.