Odyssee [odʏˈseː], Bedeutung laut Duden: lange Irrfahrt; lange, mit vielen Schwierigkeiten verbundene, abenteuerliche Reise.

Kein Begriff könnte treffender sein für die letzten Monate, in denen ich bis an den Rand der Verzweiflung versucht habe meine Geforce GTX 980Ti durch ein neues Modell zu ersetzen. Sie ist leider nach acht Jahren kaputt gegangen. Und der Zeitpunkt, an dem meine geliebte GTX 980Ti das Zeitliche gesegnet hat, war ein denkbar ungünstiger. Am 14.03.2023 schrieb ich noch sinngemäß unter Rondrers Eintrag, dass es ein absolut bescheuerter Zeitpunkt zum Kauf einer Grafikkarte sei und ich daher – trotz dringendem Bedarf an mehr Grafikleistung – noch weiter abwarten werde. Nun, nur kurze Zeit später fing dann mein PC an mit einem deutlich wahrnehmbaren Netzteil-Klacken abzustürzen, sobald eine 3D-Anwendung gestartet wurde.

CPU und RAM konnten schnell als Fehlerursache ausgeschlossen werden, womit als Hauptverdächtige nur noch Netzteil und Grafikkarte übrigblieben. Da auf meinem bequiet!-Netzteil (Straight Power 11 650W) noch Garantie war und ich aus o.g. Gründen wenig Lust hatte, mir eine neue Grafikkarte zu kaufen, griff ich erstmal zum Hörer und kontaktierte den bequiet!-Kundendienst. Zu meiner Überraschung landete ich nicht etwa in einer Warteschleife, sondern erreichte direkt einen sehr freundlichen, sehr kompetenten und – das ist ja heutzutage auch nicht mehr selbstverständlich – deutschen Muttersprachler. Dieser sah die Möglichkeit, dass im Netzteil wegen eines Defekts ggf. fälschlicherweise eine Schutzschaltung aktiviert werde, weswegen ich es einschicken solle. Gesagt getan. Kurze Fehlerbeschreibung beigefügt und freundlich angefragt, ob denn – sofern ein Defekt festgestellt werde – ein Austausch gegen ein stärkeres Netzteil (nötigenfalls auch gegen Zahlung eines Aufpreises) möglich wäre. Knapp zwei Wochen später (statt der in Aussicht gestellten 3-5 Werktage) übergab mir der Postbote ein Paket, in dem sich ein nagelneues Straight Power 11 750W* befand. Und dies, obwohl kein Defekt meines Netzteils festgestellt werden konnte! Das muss man mal festhalten und ausdrücklich loben: obwohl kein Fehler festgestellt wurde, habe ich kostenlos ein stärkeres und nagelneues Netzteil erhalten! Schöner Nebeneffekt: statt der vormals zwei PCI-e-Anschlüsse verfügt das 750W-Netzteil über deren drei. Die Zukunftssicherheit hat also gleich in zwei Bereichen zugelegt. Perfekt wäre natürlich ein 850W-Netzteil mit neuem 12VHPWR-Stecker gewesen. Aber gut, das wäre dann wirklich zu viel verlangt gewesen ![]() .

.

So groß die Freude über dieses unverhoffte Upgrade war, so schmerzhaft war die Erkenntnis, dass es nun doch die Grafikkarte ist, die für die Abstürze verantwortlich ist. Da ich jedoch weiterhin aus o.g. Gründen stur blieb und sowieso zu dem Zeitpunkt nur 2D-Spiele spielte, entschied ich mich weiter gegen einen Neukauf. Die nächste Erschütterung ließ nicht lange auf sich warten, denn kurze Zeit später stellte die Grafikkarte nun auch ihren Dienst in 2D ein.

Überraschung!

Ich hatte mich schon damit abgefunden nun doch eine neue Grafikkarte kaufen zu müssen. Aber als ich dabei war meine 980Ti zwecks Weiterverkauf auf Ebay in ihre Originalverpackung zu verpacken (ja, die habe ich seit 2015 aufbewahrt), entdeckte ich, dass sich dort tatsächlich noch die Vorgängerin versteckte – die uralte GTX 560 von EVGA. Das hatte ich ganz vergessen. Also: die GTX 560 installiert und damit den PC wenigstens wieder lauffähig gemacht. Mangels passendem DVI-I-D-Kabel war ich aber auf 1920×1080 und 60Hz beschränkt, was bei einem 1440p-Monitor mit 144Hz schon echt bescheiden aussieht. Ein paar Wochen gab ich mich damit zufrieden, aber schlussendlich – auch, weil nicht erkennbar ist, dass die Grafikkartenpreise in absehbarer Zeit signifikant sinken werden – entschied ich mich dann doch final für den Neukauf einer Grafikkarte.

Und trotz des langen Vorgeplänkels begann die eigentliche Odyssee erst jetzt…

Anlaufschwierigkeiten

Auf die ungünstige Marktlage (viel zu teure Preise für das jeweils Gebotene) und die Gründe, warum es für mich unbedingt eine nVidia-Grafikkarte sein muss (u.a. G-SYNC-Abhängigkeit), möchte ich an dieser Stelle gar nicht im Detail eingehen. Letztendlich musste ich mich aber zwischen einer Geforce RTX 4070* für 600-650 € und einer RTX 4080* für 1200-1250 € entscheiden.

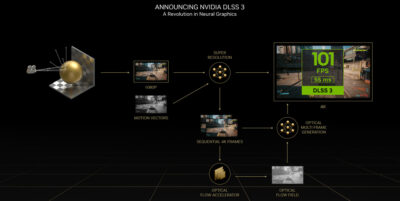

Die Vorteile der 4070 sind ihre vergleichsweise geringe Größe, das relativ geringe Gewicht, der nur einzelne und bewährte 8-Pin-Stromanschluss und das im direkten Vergleich mit der 4080 etwas bessere Preis-Leistungs-Verhältnis. Kurzum: ich bräuchte keine Grafikkartenstütze und kein Adapterkabel, sondern könnte einfach nur die alte Grafikkarte durch die neue ersetzen. Schön bequem also. Und natürlich würde ich 600 € sparen. Der große Haken: mit nur 12GB VRAM kommt die 4070 bereits heute bei einigen (schlecht programmierten) Spielen an ihre Grenzen und generell reicht ihre Leistung nicht durchweg für 4K. Zwar nutze ich aktuell nur einen 1440p-Monitor. Aber von großer Zukunftssicherheit kann man bei der 4070 nicht sprechen, wenn man den Anspruch hat sämtliche Spiele auf maximalen Einstellungen, mit Raytracing und ohne Skalierung (DLSS) und Zwischenbildberechnung (DLSS Frame Generation) ruckelfrei zu spielen. Weder in 1440p und noch weniger in 4K.

Hier spielt die 4080 mit ihren 16GB VRAM und dem generellen Plus an Leistung (50-60%) natürlich ihre Trümpfe aus. Doch abgesehen davon, dass für jene 50-60% Mehrleistung ein Preisaufschlag von etwa 100% fällig ist, bleibt dennoch fraglich, ob man mit einer 4080 tatsächlich so viel mehr Zukunftssicherheit erhält. Ich für meinen Teil habe diese Frage mit “Nein” beantwortet. Erst eine 4090 böte diese weitreichende Zukunftssicherheit. Aber bei Preisen von über 1600 € steige dann auch ich als Hardware-Enthusiast endgültig aus. Dazu noch die Unannehmlichkeiten beim Einbau, die Unsicherheit bzgl. des umstrittenen 12VHPWR-Stromanschlusses und im Übrigen zudem die Tatsache, dass nVidia – im Gegensatz zu AMD – noch keine DisplayPort 2.0-Anschlüsse verbaut. Nein, dafür wollte ich nicht so viel Geld in die Hand nehmen. Es sollte also eine RTX 4070 werden.

1. Versuch

Entgegen meiner bewährten Devise, keine Billigprodukte zu kaufen, entschied ich mich ob der horrenden Preissituation nun doch erstmals dazu, das günstigste Produkt zu kaufen: eine Palit GeForce RTX 4070 Dual. Preispunkt: 599 € zzgl. Versand. Da meine defekte GTX 980Ti auch von Palit stammte und über (immerhin!) acht Jahre lang ihren Dienst zuverlässig verrichtet hatte, wollte ich dem Unternehmen eine erneute Chance geben. Karte gekauft, eingebaut. Ekelhaft ratternde Lüfter. Ausgebaut. Zurückgeschickt. 10 Tage auf Erstattung des Kaufpreises (natürlich ohne Versandkosten) gewartet.

2. Versuch

Ok, ich sehe es ein: drei Lüfter kühlen besser als zwei und sie brauchen auch weniger Umdrehungen pro Minute – sind also theoretisch leiser. Weitere Recherchen ergaben, dass das Modell GeForce 4070 EX Gamer* von KFA2 sehr hochwertig (acht Phasen) und leise sei. Bestellt für 645 € inkl. Code für Diablo IV*. Eingebaut. Tolles RGB-Spektakel. Sehr leise. 3D-Mark angeworfen. Plötzlich höllisch laut. Lüfterdrehzahl bei nahezu 100%. Dennoch Temperaturwerte von über 70° (Norm: ca. 60°) und Hotspot-Temperatur bei knapp 90° (Norm: 75°). Definitiv nicht normal! Ausgebaut. Zurückgeschickt. 10 Tage auf Erstattung des Kaufpreises gewartet. Trotzdem vom Händler per E-Mail Code für Diablo IV erhalten – bisschen komisch, aber kann ich ja – mangels berechtigter Grafikkarte (4070 aufwärts) eh nicht einlösen.

3. Versuch

Dritter Versuch, dritter Händler. Dieses Mal Amazon*. Und dieses Mal wieder der Griff zu einem “alteingesessenen” Unternehmen: Gigabyte. Konkret: die GeForce RTX 4070 Eagle OC* für 660 €. Dazu wurde von Amazon die Zugabe eines Gutscheins für einen 33%-Nachlass auf einen dreimonatigen PC Game Pass beworben. Statt 30 € zahlt man also 20 €. Nun gut, nimmt man mal mit. Bestellt. Geliefert. Eingebaut. Läuft. Zwar auch dieses Mal spürbar heißer als in den Testberichten (ca. 10°C mehr!), aber immerhin von der Lautstärke erträglich. Ich entscheide mich die Grafikkarte zu behalten und schiebe die erhöhten Temperaturen auf eine wohl ungünstige Gehäusebelüftung sowie die sommerlichen Temperaturen. Drei Tage später fällt mir auf: wo ist denn eigentlich mein Code für den reduzierten PC Game Pass? Wurde mir wohl nicht geschickt. Kontaktaufnahme zu Amazon per Service-Chat. Wartezeit weniger als zwei Minuten – Klasse! Nachdem ich dort dem, offenkundig nicht deutschen aber sehr freundlichen Mitarbeiter erklärt habe, dass es diese Werbeaktion überhaupt gibt und worum es sich dabei handelt, erhielt ich das Angebot, dass man mir für die Unannehmlichkeiten einen Rabatt in Höhe von 10% auf den Kaufpreis der Grafikkarte anbietet. Also 66 €. Das war natürlich eine Hausnummer. Mir sind 10 € entgangen und man bietet mir als Entschuldigung 66 €. Ob das nun die Inkompetenz des Mitarbeiters oder eine sehr entgegenkommende Unternehmenspolitik war: ich habe natürlich akzeptiert.

Den Diablo IV-Code konnte ich im Übrigen auch noch aktivieren, da ich ja zwischenzeitlich doch noch eine berechtigte Grafikkarte erworben und im Aktionszeitraum aktiviert habe.

Fazit

Ich fasse zusammen: drei Versuche, drei Händler. Zwei Mal gab es offenkundige Mängel am Produkt. Zwei Mal gab es (für mich persönlich immerhin erfreuliche) “Auffälligkeiten” seitens der Händler. Ob man das mit “dem Service” nun gutheißen mag oder nicht: mir persönlich wäre es lieber gewesen, wenn einfach alles beim ersten Versuch geklappt hätte. Diablo IV-Code und 10%-Nachlass hin oder her. Irgendwie scheint “Qualität” oder “Kompetenz” nirgends mehr groß geschrieben zu werden.

Naja, wenn ich die beiden “Geschenke” nun verrechne, habe ich statt der ursprünglichen 660 € nun etwa 540 € bezahlt. Das macht den Malus mit den nur 12GB VRAM etwas erträglicher. Zudem werkelt nun ein nagelneues, stärkeres Netzteil in meinem Rechner. Alles irgendwie bizarr und surreal.

Aber gut: Ich hoffe, dass die erworbene Gigabyte-Grafikkarte nun ähnlich lange und zuverlässig ihren Dienst verrichtet wie ihre Vorgängerin. Wobei: der Umstieg auf einen 32″-UHD-OLED ist ja bereits fest eingeplant. Nur erscheinen muss dieser noch. Das ist aber wohl erst 2025 so weit. Dann geht das Spiel von vorne los – aber hoffentlich etwas weniger nervenaufreibend ![]() .

.