Nach den ersten beiden Teilen meines kleinen Hardwareausblicks, die sich auf die Themen Prozessoren und Chipsätze konzentrierten, habt ihr nun wie angekündigt den letzten und mit Abstand interessantesten Teil vor euch auf dem Bildschirm. Und Bildschirm ist da ein ganz tolles Stichwort, denn es soll heute um das große Thema des Visuellen gehen.

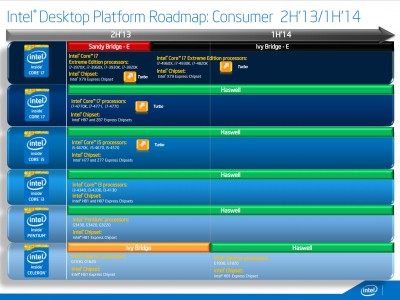

Bevor wir in die Thematik einsteigen jedoch aus aktuellem Anlass noch die Information, dass Intel zwischenzeitlich angekündigt hat, die neuen 100er-Chipsatzgeneration für Skylake mit bedeutend mehr und zudem signifikant schneller angebundenen PCIe-lanes auszustatten. Damit wird einer meiner elementaren Kritikpunkte an den letztjährigen Generationen ausgemerzt und die Kombination Intel Skylake + 100er Chipsatz bedeutend attraktiver. Insbesondere für SSDs, die in Zukunft – zumindest in Systemen von Enthusiasten – allesamt von den S-ATA-Ports in die PCIe-Slots wechseln dürften, ist das eine herausragende Nachricht. Meine Empfehlung für aufrüstwillige Desktopnutzer kann jetzt also endgültig nur noch lauten: Broadwell auslassen und auf Skylake warten. Alles andere wäre absurd.

Aber nun zum eigentlichen Thema: Grafik und Bildwiedergabe. Wer mich kennt, weiß, dass das ein Gebiet ist, das mich besonders reizt. Aber was hier bis Ende 2015 auf uns zukommt, sollte jeden halbwegs Technikinteressierten und allem voran natürlich Gamer interessieren. Eine vielversprechende GPU-Generation, hochwertige, mit neuen Funktionen ausgestattete und erschwingliche 4K-Bildschirme, DirectX 12 (im Zuge von Windows 9) und natürlich Oculus Rift. Hier ist für jeden was dabei. Und jede einzelne dieser neuen Entwicklungen bringt spürbare, teils revolutionäre Fortschritte. Holt man sich das Gesamtpaket, so wird man natürlich umso mehr fasziniert sein. Aber eines nach dem anderen.

Neue GPU-Generation

GeForce GTX 750 Ti (Herstellerbild)

Normalerweise ist es relativ langweilig, über neue Grafikkarten zu berichten. Die grobe Formel “20%-30% mehr Leistung bei idealerweise etwas weniger Verbrauch” gilt als etabliert. Was nVidia mit seiner neuen Maxwell-Architektur abliefert, hat es jedoch verdient, besonders hervorgehoben zu werden. Bislang gibt es nur zwei Desktopkarten dieser Generation: die GTX750 und GTX750Ti. Aber die haben es durchaus in sich. Während das Leistungsniveau der Bezeichnung entsprechend wenig überraschend im unteren Mittelklassebereich liegt, ist die Energieeffizienz auf Referenzniveau. Eine vergleichbar leistungsstarke Karte der Vorgängergeneration (z.B. die GTX650Ti Boost) zieht zwischen 40 und 50 Watt mehr aus der Steckdose. Anders gerechnet kann man ebenso sagen, dass eine GTX750Ti 40% mehr Leistung bietet als eine andere Grafikkarte mit ähnlichem Stromverbrauch. Entsprechend niedrig sind auch Temperaturentwicklung und Geräuschniveau (es gibt sogar komplett lüfterlose Karten). Zudem werden – je nach Hersteller – auch keine zusätzlichen Stromkabel benötigt. Und das ist – abseits aller Zahlenspielereien – einfach nur beeindruckend. Wer sich mit 30fps oder mittleren Grafikeinstellungen begnügt, bekommt für knapp 130 Euro eine Grafikkarte, die sehr sparsam, sehr leise und relativ kühl ist. Stark. Erste Oberklassekarten mit der neuen Architektur sind für das vierte Quartal 2014 angekündigt. Erste Gerüchte besagen, dass eine mögliche GTX880 etwa 20-30% schneller als eine GTX780Ti sein soll. Soviel also zur neuen Architektur.

Das wirklich interessante ist jedoch, dass alle diese Karten noch in 28nm gefertigt sind. Mit dem für Anfang/Mitte 2015 erwarteten Sprung auf 20nm (oder gar 16nm) sollte sich die Energieeffizienz nochmals spürbar verbessern. Ebenso werden im nächsten Jahr neue Schnittstellen in die Grafikkarten einziehen: HDMI 2.0 (wichtig für 4K @ 60Hz an Wiedergabegeräten ohne Display Port – also vornehmlich Fernsehern) und Display Port 1.2a bzw. 1.3 (wichtig für die Adaptive Sync Technologie, die dafür sorgt, dass sich die Bildfrequenz des Monitors an die fps-Rate anpasst und dadurch Zeilenverschiebungen eliminiert werden). Zudem, und das ist eine weitere, sehr erfreuliche Nachricht, wird ersten Gerüchten zufolge auch bereits DirectX12 vollumfänglich unterstützt.

Wir halten also fest:

- Neue, spürbar verbesserte Architektur

- Neuer Fertigungsprozess in 20nm/16nm

- Neue Schnittstellen (HDMI 2.0, DP 1.2a)

- Unterstützung von DX12

Neue Bildschirme

Redet man über die Leistungsfähigkeit und technische Ausstattung von Computern, denkt man zumeist an die Innereien des Gehäuses und nur selten an jenes Gerät, das einem die Leistung des Rechners auch optisch präsentiert. Das ist insofern verständlich, als das sich im Bereich Bildschirme seit Jahren nicht mehr viel getan hat. Andererseits entscheidet sich hier maßgeblich, ob die von der GPU berechnete Grafikpracht auch unverfälscht dem Nutzer präsentiert wird. Erfreulicherweise kommen einige sehr interessante Weiter- und Neuentwicklungen auf uns zu.

nVidia G-Sync Chip (Herstellerkonzept)

Die offensichtlichste Neuerung hat bereits Einzug auf den Markt gehalten: Ultra High Definition (UHD). Gemeint ist damit die Auflösung von 3840*2160 und damit die vierfache Pixelanzahl wie bei dem heute gängigen FHD-Pendant. Damit geht natürlich eine sichtbare Verbesserung der Bildschärfe einher. Zwar kann man sich durchaus streiten, ob man diese Auflösung bei den vergleichsweise kleinen Bildschirmen von PC-Nutzern benötigt, aber die Unterschiede sind doch bemerkenswert. Während man bei Smartphones und Tablets mittlerweile schon bei irrwitzigen Pixeldichten von ca. 550ppi angelangt ist, erreicht man selbst auf einem 28″-UHD-Monitor lediglich 157ppi. Die Verbesserung ist also tatsächlich noch sichtbar und durchaus sinnvoll, während man dies bei den heutigen Smartphones definitiv nicht mehr behaupten kann. Aber zurück zum Thema: Spiele profitieren von einer höheren Plastizität, die Arbeitsumgebung von mehr Bildfläche. Aktuell gibt es aber zu beiden Punkten starke Einschränkungen: Für Spiele in UHD und maximalen Details fehlt noch die nötige Grafikleistung, Desktoparbeiten leiden – auch unter Windows 8.1 – noch unter unzuverlässigen, oft fehlerhaften Skalierungen. Aber da wir ja in das Jahr 2015 blicken gilt hier eindeutig: UHD wird kommen und uns Gamern und Technik interessierten jede Menge Vergnügen bereiten.

Die für mich aber noch verlockendere Entwicklung sind Technologien, die die Aktualisierungsrate (refresh rate) von Monitoren an die von der GPU berechneten Bilder pro Sekunde (fps) anpasst. Seitens nVidia nennt sich das G-Sync, AMDs Pendant ist als Freesync betitelt. Die Ansätze unterscheiden sich leicht: Freesync ist herstellerunabhängig und zudem im offenen DisplayPort-Standard verankert (damit lizenzfrei), während G-Sync nur mit nVidia-Grafikkarten funktioniert und Monitore über einen entsprechenden Chip verfügen müssen. Wobei nach aktuellem Informationsstand aber auch für Freesync nicht jeder Monitor geeignet ist. Das Ergebnis ist aber dasselbe: Da sich Hz-Zahl von Monitor und Bildrate der Grafikkarte gleichen, entsteht kein hässliches und teilweise echt störendes Tearing (Zeilenverschiebungen bzw. Bildüberlagerungen) mehr. Bislang konnte man dieses Phänomen lediglich mit aktivierter vertikaler Synchronisation (VSync) bekämpfen. Hierdurch wurde eine Beschränkung der Bildrate auf (meistens) 60fps und damit exakt auf die Herzfrequenz gängiger Monitore erreicht. Allerdings muss man für diese Verbesserung in Regel einen höheren Input-Lag in Kauf nehmen. Jeder von euch sollte das schwammige und träge Gefühl von Mausbewegungen bei aktivierter vertikaler Synchronisation kennen. Für schnelle Spiele ist das also kein probates Mittel. Zudem funktioniert das ganze natürlich nur dann effektiv, wenn es die Grafikkarte auch überhaupt schafft, mindestens 60fps zu rendern – bei FullHD, maximalen Details und aktivierter Kantenglättung ist das bei den am häufigsten verbauten Mittelklassegrafikkarten keine Selbstverständlichkeit.

Asus ROG SWIFT PG278Q (Herstellerbild)

Der Vorteil der neuen Techniken liegt also auf der Hand: eine saubere, fehlerfreie Bildwiedergabe sowohl unterhalb als auch oberhalb von 60fps. Ein erster Monitor mit nVidias G-Sync ist seit Anfang August auch schon erhältlich, weitere angekündigt: Der Asus PG278Q ist ein 27″ Zoll Monitor mit einer Auflösung von 2560×1440, 1ms Reaktionszeit (grau zu grau) 144Hz-Panel und eben mit verbautem G-Sync-Modul. Dazu noch vielfach ergonomisch verstellbar und mit extrem schmalem Gehäuse. Allerdings: Es ist nur ein TN-Panel verbaut und der Preis liegt mit 800,00 € exorbitant hoch. Aber auch hier gilt: wir schauen ja auf das Jahr 2015 und bis dahin wird es das ganz sicherlich (hoffentlich) auch für 4K-Monitore und zu erschwinglicheren Preisen geben. Auf den perfekten Monitor (IPS, 4K, 1ms, 144Hz, G-Sync) wird man aber wohl vergeblich warten.

Kleiner Wehmutstropfen zum Schluss: Wer, trotz des horrenden Preises, tatsächlich von einem 3-Monitor-Setup mit oben genannten Asus-Monitoren träumt, muss bangen: G-Sync erfordert zwingend die Verwendung eines Display Ports. Da es aktuell keine nVidia-Grafikkarte mit drei (oder auch nur zwei) DPs gibt, muss auf spezielle “G-Sync-Editionen” kommender Grafikkarten gehofft werden. Oder man bastelt sich natürlich ein Triple-SLI-System – für weitere 1000-1500 Euro :smile:.

Wir fassen also auch hier zusammen:

- Auflösungen oberhalb von FHD werden Standard (2560×1440/3840×2160)

- 120Hz bzw. 144Hz werden erschwinglich

- G-Sync/FreeSync etabliert sich langsam

- Kurzum: schärfere, flüssigere und fehlerfreie Bildwiedergabe

DirectX 12

Im Zuge von Windows 9, welches neuesten Gerüchten zufolge bereits Anfang 2015 erscheinen soll, wird auch eine neue Version von DirectX auf unseren Rechnern Einzug halten. Während man damit in der Vergangenheit fast ausschließlich neue grafische Funktionen verband, zeichnet sich Version 12 durch zwei besondere Verbesserungen aus: dem Bekämpfen des Overheads und besseren (=gleichmäßigeren) Auslastung mehrerer Prozessorkerne. Analog zu AMDs Mantle-Technologie – und vielleicht auch überhaupt erst durch deren Markteinführung bedingt – widmet sich nun also auch Microsoft (sicherlich auch auf Druck von nVidia) ähnlichen Optimierungen. Die Ziele sind die gleichen: bessere Performance, also gesteigerte Bildraten insbesondere bei schwächeren Prozessoren. Tests von AMDs Mantle sind durchaus beeindruckend und unterstreichen deutlich, dass es heutzutage oftmals die Software ist, die man verbessern sollte, statt ständig nach neuer, leistungsfähigerer Hardware zu rufen. Egal ob Mantle oder DX12 – Gamer werden Grund zur Freude haben. Teils spürbare Verbesserungen zum Nulltarif nimmt man doch gerne mit. Da unabhängig davon auch Windows 9 einige sinnvolle Änderungen verspricht (und durch die ungerade Ziffer sowieso wieder gut wird), ist es nur logisch, bei dem geplanten Rechner in 2015 auch softwareseitig aufzurüsten. Nicht zuletzt durch DX12 ist das auch bedeutend zukunftssicherer.

Oculus Rift

Oculus Rift DK2 (Herstellerbild)

An dieser Stelle war ursprünglich ein umfangreicher Bericht über die wohl spannendste Entwicklung in 2015 geplant: das erstmalige Aufkommen marktreifer und hochwertiger VR-Technologie. Stattdessen erwarten euch jetzt nur einige, inhaltsleeren Zeilen. Der Grund ist einfach: Es wurde eigentlich schon alles zu dem Thema gesagt. VR und insbesondere die OR sind mittlerweile allgegenwärtig. Ich könnte hier nichts schreiben, was nicht eh schon bekannt wäre. Und da ich eine solche Brille auch noch nie selbst auf dem Kopf hatte, kann ich auch nicht von persönlichen Eindrücken berichten.

Daher nur ganz kurz: VR wird Ende 2015 “das nächste große Ding”. Da sind sich fast alle einig. Auch wenn auffällt, dass sich in der Berichterstattung langsam kritische Stimmen häufen. Auch beim aktuellen zweiten Development Kit, das über ein FHD Panel verfügt, sind die Pixel noch deutlich sichtbar. Ein Umstand, der viele Nutzer aus der Illusion herausreißt. Zudem wird der eingeschränkte Erfassungswinkel der externen Kamera bemängelt. Und nach wie vor hapert es an Software, die die Funktionen vollumfänglich und vor allem fehlerfrei nutzt. Natürlich: Es ist nach wie vor ein Entwicklerkit, zudem vergeht bis Ende 2015 noch viel Zeit. Man sollte die Erwartungen ob des enormen anfänglichen Hypes aber dennoch nicht zu hoch setzen. Zumindest die erste erwerbbare Version dürfte noch nicht “perfekt” sein. Zu dem hier skizzierten “Nerd-Rechner” in 2015 gehört VR aber zweifelsohne dazu.

Zusammenfassung

Der Kaufbefehl ergeht somit wie folgt:

Prozessor: Intel Skylake…

Mainboard: …mit 100er-Chipsatz

Grafikkarte: nVidia Maxwell in 20nm/16nm

Monitore: mindestens 1x2560x1440 mit 144Hz und G-Sync

Software: Windows 9 (wegen DX12)

Zubehör: Oculus Rift

Und wer es richtig ernst meint, kauft sich ausschließlich PCIe-SSDs, die auf NVMe setzen. Dazu schreib ich zwar auf absehbare Zeit keinen Artikel, aber das wird ebenfalls eine dieser vielen “beeindruckenden Weiterentwicklungen in 2015” werden.

Nun verabschiede ich mich mit dem gut gemeinten Rat: Spart alle schon einmal ordentlich Geld bis Ende 2015, denn das oben genannte System dürfte mindestens 3000 Euro kosten  .

.